La nanotecnología es un campo de las ciencias aplicadas dedicado al control y manipulación de la materia a una escala menor que un micrómetro, es decir, a nivel de átomos y moléculas (nanomateriales). Lo más habitual es que tal manipulación se produzca en un rango de entre uno y cien nanómetros. Se tiene una idea de lo pequeño que puede ser un nanobot sabiendo que un nanobot de unos 50 nm tiene el tamaño de 5 capas de moléculas o átomos -depende de qué esté hecho el nanobot-.

Nano es un prefijo griego que indica una medida (10-9

= 0,000 000 001), no un objeto; de manera que la nanotecnología se

caracteriza por ser un campo esencialmente multidisciplinar, y

cohesionado exclusivamente por la escala de la materia con la que

trabaja.

La nanotecnología comprende el estudio, diseño, creación, síntesis,

manipulación y aplicación de materiales, aparatos y sistemas funcionales

a través del control de la materia a nanoescala, y la explotación de

fenómenos y propiedades de la materia a nanoescala. Cuando se manipula

la materia a escala tan minúscula, presenta fenómenos y propiedades

totalmente nuevas. Por lo tanto, los científicos utilizan la

nanotecnología para crear materiales, aparatos y sistemas novedosos y

poco costosos con propiedades únicas.

Una de las aplicaciones de la nanotecnología en el campo de envases

para alimentación es la aplicación de materiales aditivados con nanoarcillas,

que mejoren las propiedades mecánicas, térmicas, barrera a los gases,

entre otras; de los materiales de envasado. En el caso de mejora de la

barrera a los gases, las nanoarcillas crean un recorrido tortuoso para

la difusión de las moléculas gaseosas, lo cual permite conseguir una

barrera similar con espesores inferiores, reduciendo así los costos

asociados a los materiales.

Los procesos de incorporación de las nanopartículas se pueden

realizar mediante extrusión o por recubrimiento, y los parámetros a

controlar en el proceso de aditivación de los materiales son: la

dispersión nanopartículas, la interacción de las nanopartículas con la

matriz, las agregaciones que puedan tener lugar entre las nanopartículas

y la cantidad de nanopartículas incorporada.

lunes, 25 de febrero de 2013

lunes, 18 de febrero de 2013

La Física Mesocópica

La Fisica mesoscópica se dedica al estudio de sistemas microscópicos (grupos de átomos)

cuyas propiedades sean significativamente diferentes al material

masivo. Dicho de otra manera, en las estructuras mesoscópicas las

propiedades físicas están alteradas por efecto del tamaño. Sin embargo,

el tamaño a partir del cual un sistema comienza a comportarse como

sistema mesoscópico depende fuertemente del material particular.

lunes, 11 de febrero de 2013

Sistemas Complejos

Un sistema complejo está compuesto por varias partes interconectadas o entrelazadas

cuyos vínculos crean información adicional no visible antes por el

observador. Como resultado de las interacciones entre elementos, surgen

propiedades nuevas que no pueden explicarse a partir de las propiedades

de los elementos aislados. Dichas propiedades se denominan propiedades emergentes.

En contraposición, el sistema complicado también está formado por varias partes pero los enlaces entre éstas no añaden información adicional. Nos basta con saber cómo funciona cada una de ellas para entender el sistema. En un sistema complejo, en cambio, existen variables ocultas cuyo desconocimiento nos impide analizar el sistema con precisión. Así pues, un sistema complejo, posee más información que la que da cada parte independientemente. Para describir un sistema complejo hace falta no solo conocer el funcionamiento de las partes sino conocer como se relacionan entre sí.

En contraposición, el sistema complicado también está formado por varias partes pero los enlaces entre éstas no añaden información adicional. Nos basta con saber cómo funciona cada una de ellas para entender el sistema. En un sistema complejo, en cambio, existen variables ocultas cuyo desconocimiento nos impide analizar el sistema con precisión. Así pues, un sistema complejo, posee más información que la que da cada parte independientemente. Para describir un sistema complejo hace falta no solo conocer el funcionamiento de las partes sino conocer como se relacionan entre sí.

lunes, 4 de febrero de 2013

La Física Termodinámica fuera del equilibrio.

Un concepto importante en termodinámica es el de variable de estado. Las variables de estado son

Un concepto importante en termodinámica es el de variable de estado. Las variables de estado sonaquéllas que una vez determinadas, especifican de manera única el estado termodinámico del

sistema. Ejemplos son la temperatura, presión, volumen y masa de los diferentes componentes en

el sistema dado. Para especificar las variables de un sistema es común ponerlo en contacto con un

baño. El baño es cualquier conjunto de fuentes (de energía, volumen, masa, etc.) lo

suficientemente grande como para no ser afectado por la interacción con el sistema de estudio. El

baño hace posible que un sistema pueda alcanzar una temperatura, presión, volumen y

concentraciones de masa determinados. Los estados de equilibrio del sistema pueden entonces

alcanzarse cuando éste es puesto en contacto térmico con el baño (con todas las fuentes

relevantes) y se espera hasta que las propiedades del sistema hayan relajado hasta los valores de

equilibrio. Bajo tales condiciones, las propiedades del sistema no cambian con el tiempo y los

valores netos promedio de calor/trabajo/masa intercambiados entre el sistema y el baño son cero.

En general, un estado de no-equilibrio se produce cada vez que las propiedades del sistema

cambian con el tiempo y/o el calor/trabajo/masa intercambiados entre el sistema y el baño son

distintos de cero. Podemos distinguir al menos tres tipos de estados de no-equilibrio:

• Transitorios. El sistema se prepara inicialmente en un estado de equilibrio y después

se lleva fuera del equilibrio activando una perturbación externa. El sistema regresa

rápidamente a un nuevo estado de equilibrio una vez que la perturbación externa deja

de cambiar.

• Estacionario. El sistema es llevado mediante fuerzas externas (dependientes del

tiempo o no conservativas) a un estado de no-equilibrio en donde sus propiedades

macroscópicas no cambian con el tiempo. El estado estacionario es un proceso

irreversible de no-equilibrio que no puede ser descrito por la distribución de

Boltzmann-Gibbs (o canónica). En el estado estacionario, el calor medio disipado por

el sistema (igual a la entropía producida por el baño) es positivo.

Existen otras categorías de estados de no-equilibrio estacionario. Por ejemplo, los

estados de no-equilibrio estacionario transitorio, en los que el sistema empieza en un

estado estacionario y efectúa transiciones entre diferentes estados estacionarios.

Fig. 3: Despliegue mecánico de una horquilla de ARN. En el experimento, la horquilla era extendida mediante asas

moleculares de ADN, que a su vez estaban conectadas a sendas microesferas de poliestireno. Una de las

esferas es atrapada rígidamente por succión en una micropipeta. La otra microesfera es atrapada mediante

unas pinzas ópticas, que permiten medir la fuerza que se ejerce sobre la horquilla de ARN cuando se mueve

la micropipeta hacia la derecha con una fuerza F.

• De envejecimiento. El sistema se prepara en un estado de no-equilibrio y se pone en

contacto con las fuentes. Entonces, se le deja evolucionar por sí solo pero no alcanza

el equilibrio termodinámico en una escala temporal observable o de laboratorio. En

este caso el sistema se encuentra en un estado que tiende lentamente al equilibrio, y

se denomina estado de envejecimiento. Se caracteriza por una producción muy

pequeña de entropía de las fuentes. En el estado de envejecimiento las correlaciones a

dos tiempos decaen conforme el sistema va evolucionando. Las funciones de

correlación dependen de ambos tiempos y no simplemente de su diferencia.

Al establecer las diferentes clases de estados de no-equilibrio no hemos considerado si el sistema

era macroscópico o pequeño. En los sistemas pequeños es común hablar del parámetro de control

para enfatizar la importancia de las ligaduras impuestas por el baño, que se controlan

externamente y no fluctúan. El parámetro de control, λ, representa un valor (en general, un

conjunto de valores) que define el estado del baño. Su valor determina las propiedades de

equilibrio del sistema, es decir, la ecuación de estado. En sistemas macroscópicos no es necesario

discernir qué valor es controlado externamente puesto que las fluctuaciones son pequeñas y todas

las colectividades de equilibrio dan lugar a la misma descripción termodinámica, es decir, a la

misma ecuación de estado. Las diferencias aparecen sólo cuando se incluyen las fluctuaciones en

la descripción. El comportamiento de no-equilibrio de los sistemas pequeños es entonces

fuertemente dependiente del protocolo usado para conducirlo fuera del equilibro. El protocolo

está generalmente definido por la evolución temporal del parámetro de control λ(t). Como

consecuencia, la caracterización del protocolo λ(t) es un paso esencial para definir sin

ambigüedades el estado de no-equilibrio. Tras la repetición del mismo experimento un número

infinito de veces con el mismo protocolo λ(t), se llega a una distribución de calor/trabajo que

caracteriza al protocolo λ(t). Este parámetro puede indicar cualquier clase de variable controlada

externamente que determine el estado del sistema, como por ejemplo, el valor de un campo

magnético externo aplicado en un sistema magnético, el valor de una fuerza mecánica aplicada en

los extremos de una molécula (véase la Fig. 3), la posición de un pistón que contiene un gas o las

concentraciones de ATP y ADP en una reacción molecular acoplada a la hidrólisis. Su variación

temporal,λ , se usa como parámetro sintonizable para determinar cuán irreversible es el proceso

de no-equilibrio.

lunes, 28 de enero de 2013

La Física de Gravitación

Todos los objetos son atraídos hacia la Tierra. La fuerza ejercida

por la Tierra sobre los objetos se denomina fuerza de gravedad. La

gravedad es una de las fuerzas fundamentales de la naturaleza. Nadie

realmente conoce exactamente porqué esta fuerza jala los objetos unos

hacia los otros. La masa de los objetos y la distancia entre ellos

afectan la magnitud de la fuerza gravitacional. A mayor masa

de los objetos y a menor distancia entre ellos mayor es la intensidad

de esa fuerza. Masas gigantes pueden atraer con mayor fuerza, mientras

que a mayor separación las fuerzas se debilitan.

La gravedad de la tierra empuja los objetos hacia el centro de la tierra y a su magnitud se

le llama peso del objeto. Cuando un objeto está en caída libre experimenta una aceleración g que actúa hacia el centro de la Tierra. Al aplicar la Segunda Ley de Newton ΣF=ma al objeto de masa m en caída libre, con a = g y ΣF = Fg, se obtiene:

En física, el campo gravitatorio o campo gravitacional es un campo de fuerzas que representa la gravedad. Si se dispone en cierta región del espacio una masa M, el espacio alrededor de M adquiere ciertas características que no disponía cuando no estaba M. Este hecho se puede comprobar acercando otra masa m y constatando que se produce la interacción. A la situación física que produce la masa M se la denomina campo gravitatorio. Afirmar que existe algo alrededor de M es puramente especulativo, ya que sólo se nota el campo cuando se coloca la otra masa m, a la que se llama masa testigo. El tratamiento que recibe este campo es diferente según las necesidades del problema:

En física, el campo gravitatorio o campo gravitacional es un campo de fuerzas que representa la gravedad. Si se dispone en cierta región del espacio una masa M, el espacio alrededor de M adquiere ciertas características que no disponía cuando no estaba M. Este hecho se puede comprobar acercando otra masa m y constatando que se produce la interacción. A la situación física que produce la masa M se la denomina campo gravitatorio. Afirmar que existe algo alrededor de M es puramente especulativo, ya que sólo se nota el campo cuando se coloca la otra masa m, a la que se llama masa testigo. El tratamiento que recibe este campo es diferente según las necesidades del problema:

La gravedad de la tierra empuja los objetos hacia el centro de la tierra y a su magnitud se

le llama peso del objeto. Cuando un objeto está en caída libre experimenta una aceleración g que actúa hacia el centro de la Tierra. Al aplicar la Segunda Ley de Newton ΣF=ma al objeto de masa m en caída libre, con a = g y ΣF = Fg, se obtiene:

En física, el campo gravitatorio o campo gravitacional es un campo de fuerzas que representa la gravedad. Si se dispone en cierta región del espacio una masa M, el espacio alrededor de M adquiere ciertas características que no disponía cuando no estaba M. Este hecho se puede comprobar acercando otra masa m y constatando que se produce la interacción. A la situación física que produce la masa M se la denomina campo gravitatorio. Afirmar que existe algo alrededor de M es puramente especulativo, ya que sólo se nota el campo cuando se coloca la otra masa m, a la que se llama masa testigo. El tratamiento que recibe este campo es diferente según las necesidades del problema:

En física, el campo gravitatorio o campo gravitacional es un campo de fuerzas que representa la gravedad. Si se dispone en cierta región del espacio una masa M, el espacio alrededor de M adquiere ciertas características que no disponía cuando no estaba M. Este hecho se puede comprobar acercando otra masa m y constatando que se produce la interacción. A la situación física que produce la masa M se la denomina campo gravitatorio. Afirmar que existe algo alrededor de M es puramente especulativo, ya que sólo se nota el campo cuando se coloca la otra masa m, a la que se llama masa testigo. El tratamiento que recibe este campo es diferente según las necesidades del problema:- En física newtoniana o física no-relativista el campo gravitatorio viene dado por un campo vectorial.

- En física relativista, el campo gravitatorio viene dado por un campo tensorial de segundo orden.

La Física de las Partículas

La física de partículas es la rama de la física que estudia los

componentes elementales de la materia y las interacciones entre ellos

como si éstas fueran partículas. Es llamada también física de altas energías,

pues muchas de las partículas elementales no se encuentran en la

naturaleza y es necesario producirlas en colisiones de alta energía

entre otras partículas, como se hace en los aceleradores de partículas Los principales centros de estudio sobre partículas son el Laboratorio Nacional Fermi o Fermilab, en EstadosUnidos, y el Centro Europeo para la Investigación Nuclear o CERN, en la frontera entre Suiza y Francia. En estos laboratorios lo que se logra es obtener energías similares a las que se cree existieron en el Big Bang, y así se intenta tener cada vez más pruebas del origen del universo.

La física de partículas es la rama de la física que estudia los

componentes elementales de la materia y las interacciones entre ellos

como si éstas fueran partículas. Es llamada también física de altas energías,

pues muchas de las partículas elementales no se encuentran en la

naturaleza y es necesario producirlas en colisiones de alta energía

entre otras partículas, como se hace en los aceleradores de partículas Los principales centros de estudio sobre partículas son el Laboratorio Nacional Fermi o Fermilab, en EstadosUnidos, y el Centro Europeo para la Investigación Nuclear o CERN, en la frontera entre Suiza y Francia. En estos laboratorios lo que se logra es obtener energías similares a las que se cree existieron en el Big Bang, y así se intenta tener cada vez más pruebas del origen del universo.En la actualidad, las partículas elementales se clasifican siguiendo el llamado Modelo Estándar en dos grandes grupos: bosones y fermiones. Los bosones son las partículas que interactúan con la materia y los fermiones son las partículas constituyentes de la materia. En el modelo estándar se explica cómo las interraciones funadmentales en forma de partículas (bosones) interactúan con las partículas de materia (fermiones). Así, el electromagnetismo tiene su partícula llamada fotón, la interacción nuclear fuerte tiene al gluón, la interacción nuclear débil a los bosones W y Z y la gravedad a una partícula hipotética llamada gravitón. Entre los fermiones hay más variedad; se encuentran dos tipos: los leptones y los quarks. En conjunto, el modelo estándar contiene 24 partículas fundamentales que constituyen la materia (12 pares de partículas/anti-partículas) junto con tres familias de bosones de gauge responsables de transportar las interacciones.

La Física Relativa

En la física relativista,

el espacio y el tiempo son propios de cada sistema de referencia y, lo

que es absoluto, es la velocidad de la luz en el vacío, es decir, para

cualquier observador, independientemente de la velocidad relativa de los

sistemas de referencia que escoja, al medir la velocidad de la luz en

cualquiera de esos sistemas, obtendrá siempre el mismo valor.

Así, la adición de velocidades de Galileo que se describe como: x' = x – vt, es sustituida por la transformación de Fitzgerald-Lorentz: x' = (x – vt) / √1 – v2 / c2, para describir que la velocidad de la luz no se suma a la del sistema de referencia.

Por otra parte, en la física relativista, la luz no se sustenta ni se ve arrastrada por ningún sistema de referencia, por tanto, cabe concluir que todas las ondas electromagnéticas se mueven en un mismo sistema de referencia.

Así, la adición de velocidades de Galileo que se describe como: x' = x – vt, es sustituida por la transformación de Fitzgerald-Lorentz: x' = (x – vt) / √1 – v2 / c2, para describir que la velocidad de la luz no se suma a la del sistema de referencia.

Por otra parte, en la física relativista, la luz no se sustenta ni se ve arrastrada por ningún sistema de referencia, por tanto, cabe concluir que todas las ondas electromagnéticas se mueven en un mismo sistema de referencia.

Más aún, en la física relativista, podemos expresar la velocidad v de cualquier sistema de referencia, desde cualquier otro, como v = nc, es decir, la velocidad tiene un patrón absoluto que no depende del estado de movimiento del observador.

Más aún, en la física relativista, podemos expresar la velocidad v de cualquier sistema de referencia, desde cualquier otro, como v = nc, es decir, la velocidad tiene un patrón absoluto que no depende del estado de movimiento del observador.Sin embargo, esto plantea un problema: se han detectado cuásares que presentan un desplazamiento hacia el rojo de las líneas espectrales que indicarían que se alejan de la Tierra a 6 veces la velocidad de la luz. Si la interpretación del efecto Doppler, o bien, del corrimiento al rojo cosmológico, fuese correcta, el concepto de velocidad definido por la física relativista carecería de sentido ya que parece improbable poder asociar a un objeto del universo una velocidad v como fracción de la velocidad de la luz mayor que la unidad.

Más aún, si el universo tiene un radio estimado de 15·109 años-luz (4,6·103 megaparsecs) y se estima que el universo se expande a razón de 68 Km/s por megaparsec, los objetos situados en el límite del universo observable desde la Tierra, hoy se alejan de nosotros aproximadamente a la velocidad de la luz.

La Física Electromagnetismo.

El electromagnetismo estudia la interacción entre cargas eléctricas, a

través del concepto de campo electromagnético. La importancia de la

teoría electromagnética hoy en día es incuestionable, dada la gran

cantidad de aplicaciones en nuestro mundo cotidiano.

El electromagnetismo es la rama de la Física

que estudia y unifica los fenómenos eléctricos y magnéticos en una sola

teoría, cuyos fundamentos fueron sentados por Michael Faraday y

formulados por primera vez de modo completo por James Clerk Maxwell. La

formulación consiste en cuatro ecuaciones diferenciales vectoriales que

relacionan el campo eléctrico, el campo magnético y sus respectivas fuentes materiales que son conocidas como ecuaciones

de Maxwell. Los conceptos relacionados a la teoría incluyen la

corriente eléctrica, polarización eléctrica y polarización magnética.

El electromagnetismo es la rama de la Física

que estudia y unifica los fenómenos eléctricos y magnéticos en una sola

teoría, cuyos fundamentos fueron sentados por Michael Faraday y

formulados por primera vez de modo completo por James Clerk Maxwell. La

formulación consiste en cuatro ecuaciones diferenciales vectoriales que

relacionan el campo eléctrico, el campo magnético y sus respectivas fuentes materiales que son conocidas como ecuaciones

de Maxwell. Los conceptos relacionados a la teoría incluyen la

corriente eléctrica, polarización eléctrica y polarización magnética.

El electromagnetismo es una teoría de campos. Las explicaciones y predicciones que provee se basan en magnitudes físicas vectoriales dependientes de la posición en el espacio y del tiempo. El electromagnetismo describe los fenómenos físicos macroscópicos en los cuales intervienen cargas eléctricas en reposo y en movimiento. Se utiliza los campos eléctricos y magnéticos y sus efectos sobre las sustancias sólidas, líquidas y gaseosas. Por ser una teoría macroscópica, es decir, aplicable sólo a un número muy grande de partículas y a distancias grandes respecto de las dimensiones de éstas, el Electromagnetismo no describe los fenómenos atómicos y moleculares, para los que es necesario usar la Mecánica Cuántica o Física Moderna.

El electromagnetismo es la rama de la Física

que estudia y unifica los fenómenos eléctricos y magnéticos en una sola

teoría, cuyos fundamentos fueron sentados por Michael Faraday y

formulados por primera vez de modo completo por James Clerk Maxwell. La

formulación consiste en cuatro ecuaciones diferenciales vectoriales que

relacionan el campo eléctrico, el campo magnético y sus respectivas fuentes materiales que son conocidas como ecuaciones

de Maxwell. Los conceptos relacionados a la teoría incluyen la

corriente eléctrica, polarización eléctrica y polarización magnética.

El electromagnetismo es la rama de la Física

que estudia y unifica los fenómenos eléctricos y magnéticos en una sola

teoría, cuyos fundamentos fueron sentados por Michael Faraday y

formulados por primera vez de modo completo por James Clerk Maxwell. La

formulación consiste en cuatro ecuaciones diferenciales vectoriales que

relacionan el campo eléctrico, el campo magnético y sus respectivas fuentes materiales que son conocidas como ecuaciones

de Maxwell. Los conceptos relacionados a la teoría incluyen la

corriente eléctrica, polarización eléctrica y polarización magnética.El electromagnetismo es una teoría de campos. Las explicaciones y predicciones que provee se basan en magnitudes físicas vectoriales dependientes de la posición en el espacio y del tiempo. El electromagnetismo describe los fenómenos físicos macroscópicos en los cuales intervienen cargas eléctricas en reposo y en movimiento. Se utiliza los campos eléctricos y magnéticos y sus efectos sobre las sustancias sólidas, líquidas y gaseosas. Por ser una teoría macroscópica, es decir, aplicable sólo a un número muy grande de partículas y a distancias grandes respecto de las dimensiones de éstas, el Electromagnetismo no describe los fenómenos atómicos y moleculares, para los que es necesario usar la Mecánica Cuántica o Física Moderna.

lunes, 21 de enero de 2013

La Física Óptica.

La física óptica, o ciencia óptica, es un subcampo de la física atómica, molecular y óptica. Es el estudio de la generación de la radiación electromagnética, las propiedades de ésa radiación, y la interacción de esa radiación con la materia, especialmente su manipulación y control. Se diferencia de la óptica general y de la ingeniería óptica,

en que está enfocada en el descubrimiento y aplicación de nuevos

fenómenos. No hay una diferencia relevante, sin embargo, entre la física

óptica, y la óptica aplicada, dado que los dispositivos de la

ingeniería óptica y los usos de la óptica aplicada son necesarios para

realizar investigación básica en la física óptica, y esa investigación

conduce al desarrollo de nuevos dispositivos y aplicaciones. A menudo

las mismas personas intervienen en el desarrollo de la investigación

básica y de la tecnología aplicada.

La física óptica, o ciencia óptica, es un subcampo de la física atómica, molecular y óptica. Es el estudio de la generación de la radiación electromagnética, las propiedades de ésa radiación, y la interacción de esa radiación con la materia, especialmente su manipulación y control. Se diferencia de la óptica general y de la ingeniería óptica,

en que está enfocada en el descubrimiento y aplicación de nuevos

fenómenos. No hay una diferencia relevante, sin embargo, entre la física

óptica, y la óptica aplicada, dado que los dispositivos de la

ingeniería óptica y los usos de la óptica aplicada son necesarios para

realizar investigación básica en la física óptica, y esa investigación

conduce al desarrollo de nuevos dispositivos y aplicaciones. A menudo

las mismas personas intervienen en el desarrollo de la investigación

básica y de la tecnología aplicada.Los investigadores en la física óptica utilizan y desarrollan fuentes de luz que abarcan todo el espectroelectromagnético desde las microondas hasta los rayos X. El campo incluye la generación y detección de la luz, procesos lineales y no lineales, y la espectroscopia Los láser y el la espectroscopia láser han transformado la ciencia óptica. Un importante campo de estudio de la física óptica es la óptica cuántica y laluz coherente, y la óptica de los femtosegundos

La física óptica, también se ocupa de brindar apoyo en áreas tales como la respuesta no linean de átomos aislados a campos electromagnéticos breves intensos, la interacción átomo-cavidad en campos intensos, y las propiedades cuánticas del campo electromagnético. Otras áreas de investigación importantes incluyen el desarrollo de las nuevas técnicas ópticas para mediciones n nanotecnologíaóptica, óptica difractiva, interferometría de baja coherencia, tomografía por coherencia óptica y la microscopía de campo cercano. La investigación en la física óptica pone énfasis en la ciencia y tecnología óptica de alta velocidad. Las aplicaciones de la física óptica crean avances en el ámbito de las telecomunicaciones, medicina, la fabricación de alimentos, e incluso entretenimiento.

lunes, 14 de enero de 2013

La Física Mecánica Ondulatoria.

La mecánica cuántica describe, en su visión más ortodoxa, cómo cualquier sistema físico, todo el universo.

Existe en una diversa y variada multiplicidad de estados, los cuales

habiendo sido organizados matemáticamente por los físicos, son

denominados autoestados de vector y valor propio. De esta forma la mecánica cuántica puede explicar y revelar la existencia del átomo y los misterios de la estructura atómica tal como hoy son entendidos; fenómenos que la física clásica, o más propiamente la mecánica clásica, no puede explicar debidamente.

Comienza a principios del siglo XX, en el momento en que dos de las teorías que intentaban explicar lo que nos rodea, la ley de gravitación universal y la teoría electromagnética clásica,

se volvían insuficientes para explicar ciertos fenómenos. La teoría

electromagnética generaba un problema cuando intentaba explicar la

emisión de radiación de cualquier objeto en equilibrio, llamada radiación térmica,

que es la que proviene de la vibración microscópica de las partículas

que lo componen. Pues bien, usando las ecuaciones de la electrodinámica

clásica, la energía que emitía esta radiación térmica daba infinito si se suman todas las frecuencias que emitía el objeto, con ilógico resultado para los físicos.

Comienza a principios del siglo XX, en el momento en que dos de las teorías que intentaban explicar lo que nos rodea, la ley de gravitación universal y la teoría electromagnética clásica,

se volvían insuficientes para explicar ciertos fenómenos. La teoría

electromagnética generaba un problema cuando intentaba explicar la

emisión de radiación de cualquier objeto en equilibrio, llamada radiación térmica,

que es la que proviene de la vibración microscópica de las partículas

que lo componen. Pues bien, usando las ecuaciones de la electrodinámica

clásica, la energía que emitía esta radiación térmica daba infinito si se suman todas las frecuencias que emitía el objeto, con ilógico resultado para los físicos.

De forma específica, se considera también mecánica cuántica, a la parte de ella misma que no incorpora la relatividad en su formalismo, tan sólo como añadido mediante la teoría de perturbaciones. La parte de la mecánica cuántica que sí incorpora elementos relativistas de manera formal y con diversos problemas, es la mecánica cuántica relativista o ya, de forma más exacta y potente, la teoría cuántica de campos (que incluye a su vez a la electrodinámica cuántica, cromodinámica cuántica y teoría electrodébil dentro del modelo estándard) y más generalmente, la teoría cuántica de campos en espacio-tiempo curvo. La única interacción que no se ha podido cuantificar ha sido la interacción gravitatoria.

Comienza a principios del siglo XX, en el momento en que dos de las teorías que intentaban explicar lo que nos rodea, la ley de gravitación universal y la teoría electromagnética clásica,

se volvían insuficientes para explicar ciertos fenómenos. La teoría

electromagnética generaba un problema cuando intentaba explicar la

emisión de radiación de cualquier objeto en equilibrio, llamada radiación térmica,

que es la que proviene de la vibración microscópica de las partículas

que lo componen. Pues bien, usando las ecuaciones de la electrodinámica

clásica, la energía que emitía esta radiación térmica daba infinito si se suman todas las frecuencias que emitía el objeto, con ilógico resultado para los físicos.

Comienza a principios del siglo XX, en el momento en que dos de las teorías que intentaban explicar lo que nos rodea, la ley de gravitación universal y la teoría electromagnética clásica,

se volvían insuficientes para explicar ciertos fenómenos. La teoría

electromagnética generaba un problema cuando intentaba explicar la

emisión de radiación de cualquier objeto en equilibrio, llamada radiación térmica,

que es la que proviene de la vibración microscópica de las partículas

que lo componen. Pues bien, usando las ecuaciones de la electrodinámica

clásica, la energía que emitía esta radiación térmica daba infinito si se suman todas las frecuencias que emitía el objeto, con ilógico resultado para los físicos.

Es en el seno de la mecánica estadística donde nacen las ideas cuánticas en 1900. Al físico alemán Max Planck se

le ocurrió un truco matemático: si en el proceso aritmético se

sustituía la integral de esas frecuencias por una suma no continua se

dejaba de obtener un infinito como resultado, con lo que eliminaba el

problema y, además, el resultado obtenido concordaba con lo que después

era medido. Fue Max Planck quien entonces enunció la hipótesis de que la

radiación electromagnética es absorbida y emitida por la materia en forma de «cuantos» de luz o fotones de energía mediante una constante estadística, que se denominó constante de Planck. Su historia es inherente al siglo XX, ya que la primera formulación cuántica de un fenómeno fue dada a conocer por el mismo Planck el 14 de diciembre de 1900 en una sesión de la Sociedad Física de la Academia de Ciencias de Berlín. La idea de Planck habría quedado muchos años sólo como hipótesis si Albert Einstein no la hubiera retomado, proponiendo que la luz, en ciertas circunstancias, se comporta como partículas de

energía independientes (los cuantos de luz o fotones). Fue Albert

Einstein quien completó en 1905 las correspondientes leyes de movimiento

con lo que se conoce como teoría especial de la relatividad, demostrando que el electromagnetismo era una teoría esencialmente no mecánica. Culminaba así lo que se ha dado en llamar física clásica, es decir, la física no-cuántica.

Usó este punto de vista llamado por él «heurístico», para desarrollar su teoría del efecto fotoeléctrico, publicando esta hipótesis en 1905, lo que le valió el Premio Nobel de Física de 1921. Esta hipótesis fue aplicada también para proponer una teoría sobre el calor específico,

es decir, la que resuelve cuál es la cantidad de calor necesaria para

aumentar en una unidad la temperatura de la unidad de masa de un cuerpo.

El siguiente paso importante se dio hacia 1925, cuando Louis de Broglie propuso que cada partícula material tiene una longitud de onda asociada, inversamente proporcional a su masa, (a la que llamó momentum), y dada por su velocidad. Poco tiempo después Erwin Schrödinger formuló una ecuación de movimiento para

las «ondas de materia», cuya existencia había propuesto de Broglie y

varios experimentos sugerían que eran reales. La mecánica cuántica

introduce una serie de hechos contraintuitivos que no aparecían en los

paradigmas físicos anteriores; con ella se descubre que el mundo atómico

no se comporta como esperaríamos. Los conceptos de incertidumbre o cuantización son

introducidos por primera vez aquí. Además la mecánica cuántica es la

teoría científica que ha proporcionado las predicciones experimentales

más exactas hasta el momento, a pesar de estar sujeta a las

probabilidades.

La teoría cuántica fue desarrollada en su forma básica a lo largo de la primera mitad del siglo XX.

El hecho de que la energía se intercambie de forma discreta se puso de

relieve por hechos experimentales como los siguientes, inexplicables con

las herramientas teóricas anteriores de la mecánica clásica o la

electrodinámica:

- Espectro de la radiación del cuerpo negro, resuelto por Max Planckjulios

- Bajo ciertas condiciones experimentales, los objetos microscópicos como los átomoselectronesondulatorio, como en la interferencia. Bajo otras condiciones, las mismas especies de objetos exhiben un comportamiento corpuscular, de partícula, («partícula» quiere decir un objeto que puede ser localizado en una región concreta del espacio), como en la dispersióndualidad onda-partícula.

- Las propiedades físicas de objetos con historias asociadas pueden ser correlacionadas, en una amplitud prohibida para cualquier teoría clásica, sólo pueden ser descritos con precisión si se hace referencia a ambos a la vez. Este fenómeno es llamado entrelazamiento cuánticodesigualdad de Bell

- Explicación del efecto fotoeléctrico, dada por Albert Einstein, en que volvió a aparecer esa "misteriosa" necesidad de cuantizar la energía.

- Efecto Compton.

Las suposiciones más importantes de esta teoría son las siguientes:

- Al ser imposible fijar a la vez la posición y el momento de una partícula, se renuncia al concepto de trayectoria, vital en mecánica clásica. En vez de eso, el movimiento de una partícula queda regido por una función matemática que asigna, a cada punto del espacio y a cada instante, la probabilidadinterpretación de Copenhague). A partir de esa función, o función de ondas, se extraen teóricamente todas las magnitudes del movimiento necesarias.

- Existen dos tipos de evolución temporal, si no ocurre ninguna medida el estado del sistema o función de ondaecuación de Schrödinger, sin embargo, si se realiza una medida sobre el sistema, éste sufre un «salto cuántico»proyección ortogonal

- Existen diferencias perceptibles entre los estados ligados y los que no lo están.

- La energía

La Física Termodinámica clásica.

La Termodinámica es una de las ramas más antiguas e importantes de la

Física. Se basa en el estudio de las características macroscópicas de un

sistema sin conocer el detalle de la física microscópica que

interviene.

Los sistemas físicos que encontramos en la Naturaleza consisten en un agregado de un número muy grande de átomos.

La materia está en uno de los tres estados: sólido, líquido o gas: En los sólidos, las posiciones relativas (distancia y orientación) de los átomos o moléculas son fijas. En los líquidos, las distancias entre las moléculas son fijas, pero su orientación relativa cambia continuamente. En los gases, las distancias entre moléculas, son en general, mucho más grandes que las dimensiones de las mismas. Las fuerzas entre las moléculas son muy débiles y se manifiestan principalmente en el momento en el que chocan. Por esta razón, los gases son más fáciles de describir que los sólidos y que los líquidos.

El gas contenido en un recipiente, está formado por un número muy grande de moléculas, 6.02·1023 moléculas en un mol de sustancia. Cuando se intenta describir un sistema con un número tan grande de partículas resulta inútil (e imposible) describir el movimiento individual de cada componente. Por lo que mediremos magnitudes que se refieren al conjunto: volumen ocupado por una masa de gas, presión que ejerce el gas sobre las paredes del recipiente y su temperatura. Estas cantidades físicas se denominan macroscópicas, en el sentido de que no se refieren al movimiento individual de cada partícula, sino del sistema en su conjunto.

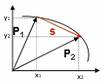

La primera ley no es otra cosa que el principio de conservación de la energía

aplicado a un sistema de muchísimas partículas. A cada estado del sistema le corresponde

una energía interna U. Cuando el sistema pasa del estado A al estado B, su

energía interna cambia en

La primera ley no es otra cosa que el principio de conservación de la energía

aplicado a un sistema de muchísimas partículas. A cada estado del sistema le corresponde

una energía interna U. Cuando el sistema pasa del estado A al estado B, su

energía interna cambia en

DU=UB-UA

Supongamos que el sistema está en el estado A y realiza un trabajo W, expandiéndose. Dicho trabajo mecánico da lugar a un cambio (disminución) de la energía interna de sistema

DU=-W

También podemos cambiar el estado del sistema poniéndolo en contacto térmico con otro sistema a diferente temperatura. Si fluye una cantidad de calor Q del segundo al primero, aumenta su energía interna en

DU=Q

Si el sistema experimenta una transformación cíclica, el cambio en la energía interna es cero, ya que se parte del estado A y se regresa al mismo estado, DU=0. Sin embargo, durante el ciclo el sistema ha efectuado un trabajo, que ha de ser proporcionado por los alrededores en forma de transferencia de calor, para preservar el principio de conservación de la energía, W=Q.

Si el estado inicial y final están muy próximos entre sí, el primer principio se

escribe

dU=dQ-pdV

Los sistemas físicos que encontramos en la Naturaleza consisten en un agregado de un número muy grande de átomos.

La materia está en uno de los tres estados: sólido, líquido o gas: En los sólidos, las posiciones relativas (distancia y orientación) de los átomos o moléculas son fijas. En los líquidos, las distancias entre las moléculas son fijas, pero su orientación relativa cambia continuamente. En los gases, las distancias entre moléculas, son en general, mucho más grandes que las dimensiones de las mismas. Las fuerzas entre las moléculas son muy débiles y se manifiestan principalmente en el momento en el que chocan. Por esta razón, los gases son más fáciles de describir que los sólidos y que los líquidos.

El gas contenido en un recipiente, está formado por un número muy grande de moléculas, 6.02·1023 moléculas en un mol de sustancia. Cuando se intenta describir un sistema con un número tan grande de partículas resulta inútil (e imposible) describir el movimiento individual de cada componente. Por lo que mediremos magnitudes que se refieren al conjunto: volumen ocupado por una masa de gas, presión que ejerce el gas sobre las paredes del recipiente y su temperatura. Estas cantidades físicas se denominan macroscópicas, en el sentido de que no se refieren al movimiento individual de cada partícula, sino del sistema en su conjunto.

La primera ley no es otra cosa que el principio de conservación de la energía

aplicado a un sistema de muchísimas partículas. A cada estado del sistema le corresponde

una energía interna U. Cuando el sistema pasa del estado A al estado B, su

energía interna cambia en

La primera ley no es otra cosa que el principio de conservación de la energía

aplicado a un sistema de muchísimas partículas. A cada estado del sistema le corresponde

una energía interna U. Cuando el sistema pasa del estado A al estado B, su

energía interna cambia enDU=UB-UA

Supongamos que el sistema está en el estado A y realiza un trabajo W, expandiéndose. Dicho trabajo mecánico da lugar a un cambio (disminución) de la energía interna de sistema

DU=-W

También podemos cambiar el estado del sistema poniéndolo en contacto térmico con otro sistema a diferente temperatura. Si fluye una cantidad de calor Q del segundo al primero, aumenta su energía interna en

DU=Q

Si el sistema experimenta una transformación cíclica, el cambio en la energía interna es cero, ya que se parte del estado A y se regresa al mismo estado, DU=0. Sin embargo, durante el ciclo el sistema ha efectuado un trabajo, que ha de ser proporcionado por los alrededores en forma de transferencia de calor, para preservar el principio de conservación de la energía, W=Q.

- Si la transformación no es cíclica DU¹ 0

- Si no se realiza trabajo mecánico DU=Q

- Si el sistema está aislado térmicamente DU=-W

- Si el sistema realiza trabajo, U disminuye

- Si se realiza trabajo sobre el sistema, U aumenta

- Si el sistema absorbe calor al ponerlo en contacto térmico con un foco a temperatura superior, U aumenta.

- Si el sistema cede calor al ponerlo en contacto térmico con un foco a una temperatura inferior, U disminuye.

| DU=Q-W |

dU=dQ-pdV

lunes, 7 de enero de 2013

La Física Mecánica clásica.

Hoy día la definimos como el área de la física que

estudia el

movimiento en su forma (cinemática) o en sus causas (dinámica).

Se

considera que Issac Newton es el padre de la mecánica moderna y que todo

empezó con una

manzana que le cayó en la cabeza pero lo cierto es que él se enfrascó en

demostrar que Galileo tenía la razón en cuanto a sus especulaciones

sobre el

movimiento y con ello termina inventando el cálculo. Lo de la manzana es

una

leyenda que al parecer viene de una de sus explicaciones en sus clases,

aunque

en realidad no hay ningún escrito que haga alguna referencia al tema.

También la

división tradicional de cinemática y dinámica queda un poco relegada a lo que

llamamos mecánica clásica pues existen tres ramas de la mecánica moderna: la

mecánica relativista, la mecánica cuántica y la teoría cuántica de los campos.

La mecánica relativista se divide en Teoría de la relatividad especial o

restringida publicada por Albert Einstein en 1905, que describe el movimiento de

los cuerpos mientras el espacio no se “curve” y la Teoría general de la

relatividad que describe el caso de la “curva” del espacio-tiempo. La teoría

resuelve una serie de problemas que la mecánica de Newton no podía aclarar (es

un hecho reconocido que la mecánica Newtoniana es un caso particular de la

teoría relativista) y por ello provocó una larga polémica.

También la

división tradicional de cinemática y dinámica queda un poco relegada a lo que

llamamos mecánica clásica pues existen tres ramas de la mecánica moderna: la

mecánica relativista, la mecánica cuántica y la teoría cuántica de los campos.

La mecánica relativista se divide en Teoría de la relatividad especial o

restringida publicada por Albert Einstein en 1905, que describe el movimiento de

los cuerpos mientras el espacio no se “curve” y la Teoría general de la

relatividad que describe el caso de la “curva” del espacio-tiempo. La teoría

resuelve una serie de problemas que la mecánica de Newton no podía aclarar (es

un hecho reconocido que la mecánica Newtoniana es un caso particular de la

teoría relativista) y por ello provocó una larga polémica.

La mecánica cuántica

o mecánica ondulatoria es la que estudia las partículas subatómicas y

cómo se

comportan como onda y partícula a la vez (a semejanza de la luz, que es

donde se

inicia este tipo de estudios). Los padres de la mecánica cuántica son

James Clerk Maxwell y Heinrich Rudolf Hertz, el primero por poner la

base teórica que

explica que cualquier objeto que viaje a una velocidad cercana a la de

la luz

emite un campo electromagnético y el segundo por demostrarlo

experimentalmente.

En cuanto a la teoría cuántica de los campos es la aplicación de la mecánica

cuántica a los campos gravitatorios, electromagnéticos y otros. A este nivel lo

que puedo comentar sobre esta área de la mecánica es que es la más reciente y es

la que trata de explicar los orígenes del universo.

La Historia de la Física y puntos a desarrollar.

La Historia de la Física

está llena de grandes científicos como Galileo, Newton o Einstein, cuyas

contribuciones han sido decisivas, pero también de un número muy grande de

científicos cuyos nombres no aparecen en los libros de texto. No existe el

genio aislado al que de repente se le ocurre la idea clave que cambia el curso

de la Ciencia. El avance en el progreso científico no se produce solamente por

las contribuciones aisladas y discontinuas de unas mentes privilegiadas.

Hay partidarios del

uso de la historia en la enseñanza de la Física por varias razones:

a)

Apreciar el estado actual de nuestro conocimiento científico en comparación

con épocas previas.

b) Como hechos que debemos conocer para

incrementar nuestra cultura.

c) Posibilidad de adquirir una visión actual y

rigurosa de la evolución de nuestra imagen del mundo físico, que está en no

pocas ocasiones en contradicción con la imagen simplificada que nos han

contado, o que presentan algunos libros de texto.

d) Motivar a estudiantes interesados en

aspectos filosóficos y sociales de la ciencia.

-

Dentro del campo de estudio de la Física Clásica se encuentran:

-

Mecánica

-

-

Dentro del campo de estudio de la Física Moderna se encuentran:

-

Relatividad

-

Mecánica cuántica: Átomo | Núcleo | Física Química | Física del estado sólido

-

Física de partículas

-

Gravitación

-

-

Dentro del campo de estudio de la Física Contemporánea se encuentran:

-

Termodinámica fuera del equilibrio: Mecánica estadística |Percolación

-

Dinámica no lineal: Turbulencia| Teoría del Caos | Fractales

-

Sistemas complejos: Sociofísica | Econofísica | Criticalidad autorganizada| Redes Complejas

-

Física mesoscópica: Puntos cuánticos

-

Nano-Física: Pinzas ópticas

-

-

En el Siglo XVI, Galileo fue pionero en el uso de experimentos para validar las teorías de la física. Se interesó en el movimiento de los astros y de los cuerpos. Usando el plano inclinado descubrió la ley de la inercia de la dinámica y con el telescopio observó que Júpiter tenía satélites girando a su alrededor.

-

En el Siglo XVII, Newton (1687) formuló las leyes clásicas de la dinámica (Leyes de Newton) y la Ley de la Gravitación Universal.

-

A partir del Siglo XVIII se produce el desarrollo de otras disciplinas tales como la termodinámica, la mecánica estadística y la física de fluídos.

-

En el Siglo XIX se producen avances fundamentales en electricidad y magnetismo. En 1855, Maxwell unificó ambos fenómenos y las respectivas teorías vigentes hasta entonces en la Teoría del electromagnetismo, descrita a través de las Ecuaciones de Maxwell. Una de las predicciones de esta teoría es que la luz es una onda electromagnética. A finales de este siglo se producen los primeros descubrimientos sobre radiactividad dando comienzo el campo de la física nuclear. En 1897, Thompson descubrió el electrón.

-

Durante el Siglo XX la Física se desarrolló plenamente. En 1904 se propuso el primer modelo del átomo. En 1905 Einstein formuló la Teoría de la Relatividad Especial, la cual coincide con las Leyes de Newton cuando los fenómenos se desarrollan a velocidades pequeñas comparadas con la velocidad de la luz. En 1915 Einstein extendió la Teoría de la Relatividad especial formulando la Teoría de la Relatividad General, la cual sustituye a la Ley de gravitación de Newton y la comprende en los casos de masas pequeñas. Planck, Einstein, Bohr y otros desarrollaron la Teoría cuántica a fin de explicar resultados experimentales anómalos sobre la radiación de los cuerpos. En 1911 Rutherford dedujo la existencia de un núcleo atómico cargado positivamente a partir de experiencias de dispersión de partículas. En 1925, Heisenberg y en 1926 Schrödinger y Dirac formularon la Mecánica Cuántica, la cual comprende las teorías cuánticas precedentes y suministra las herramientas teóricas para la Física de la Materia Condensada. Posteriormente se formuló la Teoría cuántica de campos para extender la Mecánica cuántica de manera consistente con la Teoría de la Relatividad especial, alcanzando su forma moderna a finales de los 40 gracias al trabajo de Feynman, Schwinger, Tomonaga y Dyson, quienes formularon la Teoría de la Electrodinámica Cuántica. Asimismo, esta teoría suministró las bases para el desarrollo de la Física de Partículas. En 1954, Yang y Mills, desarrollaron las bases del Modelo Estándar. Este modelo se completó en los años 70 y con él fue posible predecir las propiedades de partículas no observadas previamente pero que fueron descubiertas sucesivamente siendo la última de ellas el quark top. En la actualidad el modelo estándar describe todas las partículas elementales observadas así como la naturaleza de su interacción.

Suscribirse a:

Entradas (Atom)